Содержание:

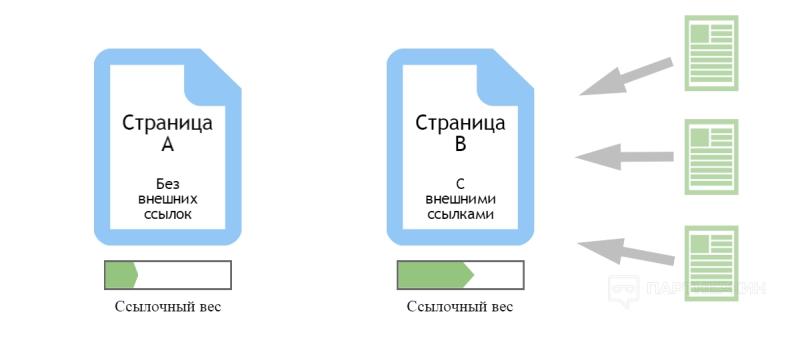

Ссылочная масса — это как мышцы сайта, потому что по ним судят о валидности содержимого, оценивают достоверность данных, а также проверяют трастовость проекта. Последний пункт особенно важен — он напрямую передается от «доноров» к «наследникам».

Можно представить сайт, который пять лет спокойно существовал, предлагая к продаже различную садовую технику. И вроде бы все хорошо, таргет настроен отлично, клиенты приходят, заказы оформляются стабильно раз в день, но… однажды владелец блога о садоводстве указал в ссылках тот самый сайт с пометкой «Можно брать, все качественно, лично убедился». Клиентский поток значительно увеличится, вслед за ним и прибыль.

Это был пример положительного эффекта от ссылок — владельцы сайта и блога вряд ли хотели навредить друг другу, так что можно поделиться трафиком и качественным товаром. Но могла произойти ситуация, что ссылка на каталог появилась бы на «спамерном» ресурсе — что это такое, какие будут последствия, как этого избежать — не только объясним, но и покажем.

Как понять, что сайт подвергся атаке спамеров

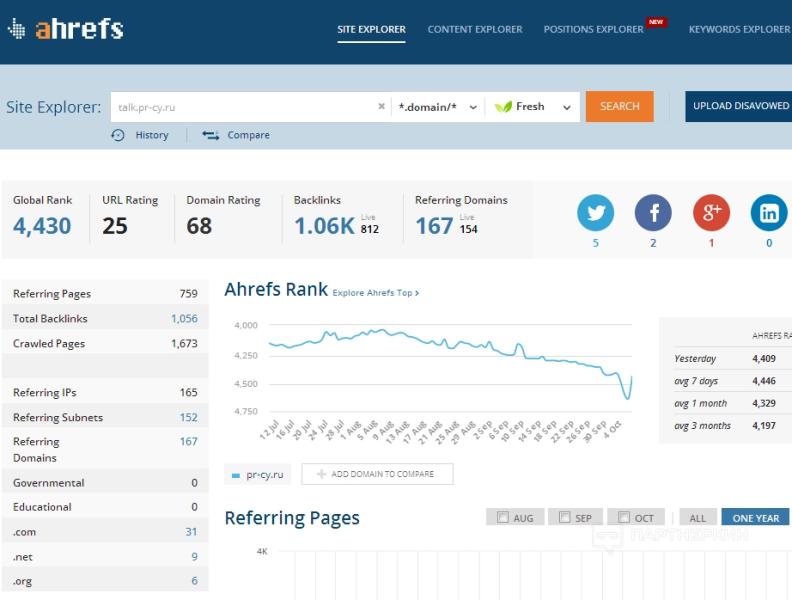

В Интернете можно найти немало сервисов для анализа ссылочной массы — например, Ahrefs или Majestic. И если заметен резкий рост с низкокачественными доменами-донорами, то это означает одно — сайт подвергся спам-атаке конкурентов.

Резкое падение рейтинга может быть обусловлено серьезными изменениями в структуре сайта, либо спам-атакой. На представленном скриншоте явно прослеживается падение из-за количества обратных ссылок (1,06 тысяч), из которых «живых» не так много (812, должно быть 1,06 тысяч). Из-за этого URL rating упал до 25 баллов (идеально — 100 баллов).

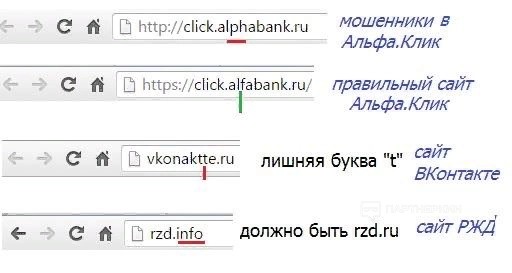

Спамные сайты-«доноры» могут прятаться под самыми разнообразными, иногда даже органичными названиями. Сервис iSEO представил целую выбору спамных проектов, в числе которых был сервис student4.postech.

Перейдя по ссылке, пользователь получит резкие «зависания» браузера из-за того, что внутри алгоритма подключена циклическая функция обновления сайта каждую секунду. Это серьезно расходует оперативную память, и не позволит увидеть отсутствие содержимого — защита от seo-анализаторов.

Как сильно ссылочный спам может навредить сайту

URL Rating — показатель ссылочной массы, который раньше не так серьезно воспринимался поисковыми системами из-за размеров интернет-сегмента. Но с ростом популярности коммерческих запросов, а также количества сайтов, которые не отказывались от возможности пиара за счет seo-«доноров», появилась специализированная система АГС, автоматически блокирующая подобные проекты в поисковой выдаче.

Данный алгоритм анализирует ссылочную массу каждого сайта, определяя целесообразность демонстрации проекта в поисковой выдаче — если у него есть много низкотрастовых «доноров», то либо время создания сервиса достаточно мало, либо seo-маркетолог не додумался ни до чего большего, чем закупиться рекламой у низкокачественных буксов, либо это спам-атака.

Низкий траст — вот основная головная боль данного алгоритма, потому что до конца определить трастовость проекта попросту невозможно. Одна спам-атака, — и сайту придется потратить много времени, чтобы вернуться в поисковик. Проще будет создать новый сервис с нуля, потому что аналоги по коду и оформлению также получают блокировки.

Зачем сеошники прячут свои ссылки (бэклинки) от конкурентов

Как говорилось ранее, некоторые seo-менеджеры не отказывают себе в возможности резкого увеличения узнаваемости бренда/товара/лендинга за счет приобретения ссылок-«доноров». Чем дороже рекламное место, тем выше вероятность попасть на высокотрастовый проект. Но схема каждый раз прокручивается одна и та же:

- Поиск конкурентных предложений (в сервисах-анализаторах).

- Выбор бэклинков внутри текстов и общей ссылочной массы, максимальное копирование креатива, алгоритма, содержимого.

- Добавление индивидуальной ценности (рерайтинг с включением seo-ссылки, добавление вотермарки на картинки).

Именно поэтому более опытные seo-шники учились «прятать» ссылки и максимально старались защищать подноготную сайта, чтобы конкуренты не воспользовались «вкусными» бэклинками. Проблема заключается в том, что опытный seo-мастер может:

- Завалить ресурс в целом, написав «донорам» от лица проекта, что ссылки более не актуальны, нужно закончить сотрудничество (другой адрес электронной почты — «взлом», например).

- Получить рабочую схему с внесением индивидуальной ценности на основе высокотрастового «донора».

- Снизить траст «донора» за счет ссылочного спама.

Основными помощниками в разведке «территории» выступают Ahrefs, Majestic и Semrush — они могут анализировать органику конкурентов, а также предоставляют доступ к бэклинкам за пару кликов.

Вариант с реализацией кода (программирование)

Лезть в корневые настройки сайта, конечно, опасно из-за возможности «сломать все и вся», однако это один из наиболее верных способов избавиться от преследования сервисов-разведчиков.

Закрыть через robots.txt

Ниже представлен пример типового файла robots.txt. Достаточно добавить пару-тройку команд, которые не позволят роботам-разведчикам брать информацию с сайта, и ни один из сервисов уже не сможет представить бэклинки конкурентам.

При этом ежегодно появляется все больше и больше ботов для этих целей.

User-agent: * Disallow: rogerbot Disallow: / #подключение бота отказа

User-agent: SemrushBot Disallow: / #отказ от анализа ботом Semrush

User-agent: xenu Disallow: / #отказ от анализа ботом Xenu

User-agent: MJ12bot Disallow: / #отказ от анализа ботом Majestic

User-agent: AhrefsBot Disallow: / #отказ от анализа ботом Ahrefs

К сожалению, ни один бот в мире не может гарантировать, что сервисы не обойдут их проверку — в частности, им нужно собирать информацию по трастам, на основании этого показателя многие поисковики принимают решение о публикации сайта в поисковой выдаче. Поэтому можно усилить охрану вторым методом.

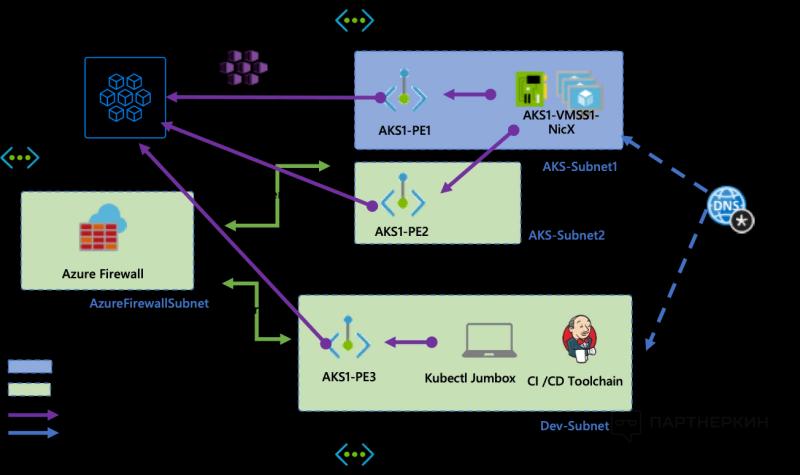

Закрыть в .htaccess

Если ранее указанный файл с подключаемыми роботами может оказаться в руках злоумышленников, то .htaccess имеется в единственном числе только у создателя сайта и отвечает за предоставление доступа к содержимому как для ботов, так и для людей (блокировка по IP).

Лучше все действия выполнять самостоятельно, потому что алгоритм достаточно простой:

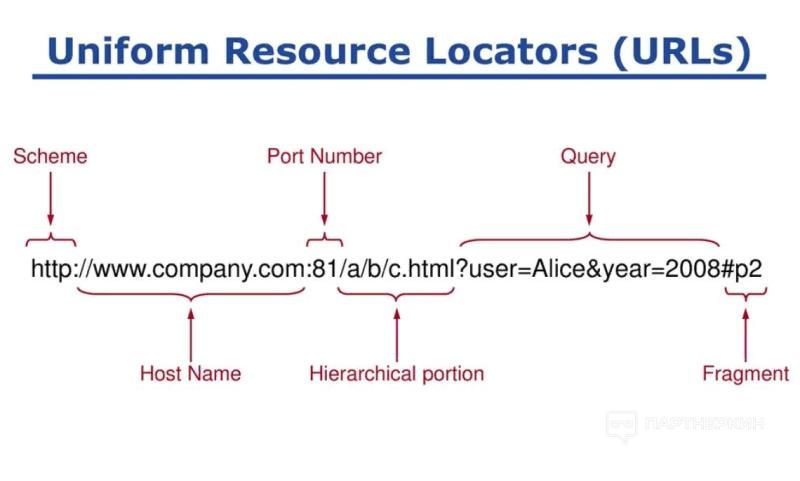

- Анализ журнала посещения (logs-файлы). IP-адреса и имена ботов, которые достаточно часто посещают проект, рекомендуется заблокировать, если не указана причина визитов (многократное выполнение целевого действия). В ряде случаев может производиться подмена названий — например, краулеры позволяют опознать себя как YandexBot или GoogleBot.

- В отношение к «подозрительным» названиям необходимо произвести проверку по IP-адресу. То есть, создать DNS-запрос (код представили ниже), а после определить хост обратным запросом — в идеале он должен быть yandex.com/.net/.ru.

- Прямой и обратный код DNS-запроса должен совпасть — то есть, IP-адрес, получаемый при обращении сайта к боту должен возвращать то же значение, которое закладывает бот при обращении к сервису. При несовпадении значений производится автоматическая блокировка.

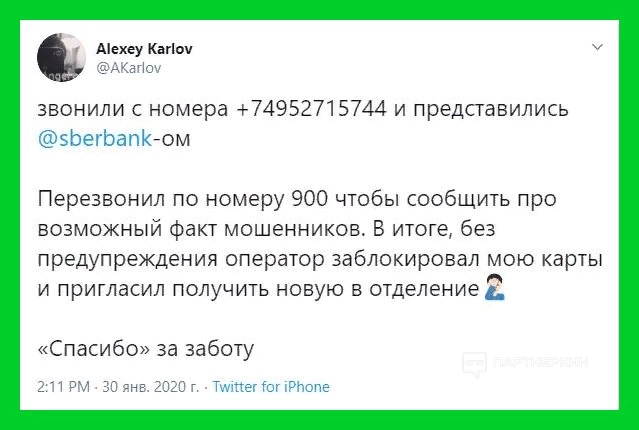

Кажется, что алгоритм очень сложный из-за своей программной интерпретации и обилия терминов. Однако, если разобраться на более простых примерах, все становится достаточно понятно:

«Виктор хочет узнать, что за номер звонил ему пару минут назад. Мошенник решил прикинуться высокотрастовой организацией, добавив в GetContact кучу определений типа «Сбербанк», «Сбербанк работа» и тому подобных, что при звонке высвечиваются именно они, а не просто пустой номер.

Именно поэтому Виктор нашел официальный номер Сбербанка и позвонил в службу клиентской поддержки, чтобы спросить (отправил прямой DNS-запрос), является ли мошеннический номер частью их дочерней телефонной системы.

Получив отрицательный/положительный ответ, он может позвонить по изначальному номеру (выполнить обратный DNS-запрос), чтобы уточнить несколько вопросов по работе приложения «Сбербанк Онлайн», однако уже по первому слову менеджера он сможет понять, что имеет дело с мошенниками — мало кто из них может подражать реальным системам ответа call-центра банка.»

Теперь стоит вернуться к части с программирование — как правильно выполнить обратный DNS-запрос. Говоря о Windows, делается это просто с помощью команды «nslookup».

Готовый код для добавления в .htaccess:

SetEnvIfNoCase User-Agent .*aboundexbot.* botstop

SetEnvIfNoCase User-Agent .*ahrefsbot.* botstop

SetEnvIfNoCase User-Agent .*backlinkcrawler.* botstop

SetEnvIfNoCase User-Agent .*blekkobo.* botstop

SetEnvIfNoCase User-Agent .*blexbot.* botstop

SetEnvIfNoCase User-Agent .*dotbot.* botstop

SetEnvIfNoCase User-Agent .*dsearch.* botstop

SetEnvIfNoCase User-Agent .*exabot.* botstop

SetEnvIfNoCase User-Agent .*ezooms.* botstop

SetEnvIfNoCase User-Agent .*gigabot.* botstop

SetEnvIfNoCase User-Agent .*ia_archiver.* botstop

SetEnvIfNoCase User-Agent .*linkdexbot.* botstop

SetEnvIfNoCase User-Agent .*lipperhey spider.* botstop

SetEnvIfNoCase User-Agent .*majestic-12.* botstop

SetEnvIfNoCase User-Agent .*majestic-seo.* botstop

SetEnvIfNoCase User-Agent .*meanpathbot.* botstop

SetEnvIfNoCase User-Agent .*megaindex.* botstop

SetEnvIfNoCase User-Agent .*mj12bot.* botstop

SetEnvIfNoCase User-Agent .*ncbot.* botstop

SetEnvIfNoCase User-Agent .*nutch.* botstop

SetEnvIfNoCase User-Agent .*pagesinventory.* botstop

SetEnvIfNoCase User-Agent .*rogerbot.* botstop

SetEnvIfNoCase User-Agent .*scoutjet.* botstop

SetEnvIfNoCase User-Agent .*searchmetricsbot.* botstop

SetEnvIfNoCase User-Agent .*semrushbot.* botstop

SetEnvIfNoCase User-Agent .*seokicks-robot.* botstop

SetEnvIfNoCase User-Agent .*sistrix.* botstop

SetEnvIfNoCase User-Agent .*sitebot.* botstop

SetEnvIfNoCase User-Agent .*spbot.* botstop

<Limit GET POST HEAD>

Order Allow,Deny

Allow from all

Deny from env=botstop

</Limit>

Для того, чтобы полностью запретить доступ краулеров к содержимому сайта, лучше всего также внести изменения в конфигурацию Apache — то есть, внести изменения как в локальный, так и глобальный файл. Но также рекомендуется перестраховаться изменениями в robots.txt.

Закрыть в .htaccess с перенаправлением на другой сайт

Даже если сервисы-анализаторы получат больше возможностей для поиска, можно их опередить и заставить не просто «потерять» доступ к сайту, но и перенаправить их на другой проект — например, Wikipedia, как самый высокотрастовый и бесполезный для анализа.

Для этого в файле .htaccess вносятся следующие изменения:

RewriteEngine On RewriteBase /

Самые высокие ставки по RU, BY, KZ от прямого рекламодателя FONBET PARTNERS! К заливам!

RewriteCond %{HTTP_USER_AGENT} .*AhrefsBot.* [OR]

RewriteCond %{HTTP_USER_AGENT} .*SemrushBot.*

RewriteRule ^(.*)$ http://www.anotherdomain.com/ [L,R=301]

Order Allow,Deny

Allow from all

Deny from 216.123.8.0/8

Deny from ….

Отсутствие обратных ссылок не доказывает, что сайт ими не пользуется от слова совсем и является «пустышкой» — Google и Яндекс находят то, что им нужно, выстраивая собственные алгоритмы анализа.

Плагины для скрытия обратных ссылок от конкурентов

Если не хочется заморачиваться с программированием, а сайт построен на одном из конструкторов, например, WordPress, можно полностью автоматизировать этот процесс за счет подключения соответствующего плагина.

Первый плагин — это Spyder Spanker , являющийся премиум-предложением, другой плагин — Link Privacy , работающий как бесплатный аналог большей части функционала. Они никоим образом не касаются локальных файлов и всего лишь служат как «щиты» для сторонних ботов.

Альтернативный вариант (без программирования)

Если доступа к программному содержимому сайту нет, то seo-менеджеры могут с легкостью воспользоваться альтернативным методом. В частности, потребуется всего лишь перевести таргетинг по иным путям:

ВАЖНО! Это никоим образом не позволяет скрыть все ссылки от мнения конкурентов, но заметно снижает интерес к продукту, из-за чего уменьшается риск DDOS-атак и спама ссылками.

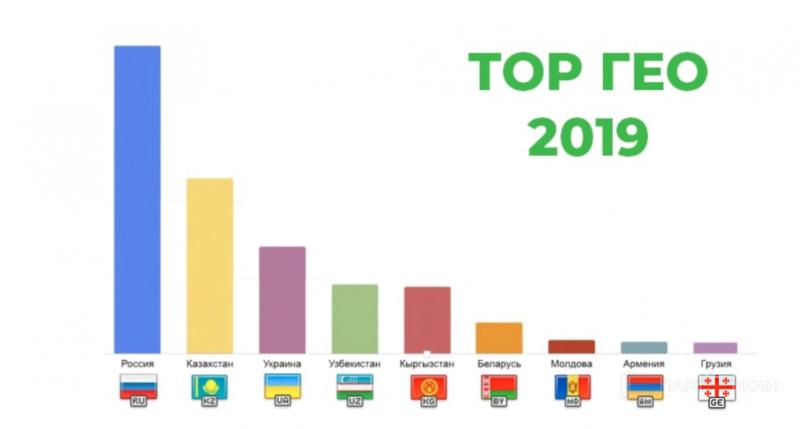

Малопопулярные ГЕО

Если проект мировой, то можно лить трафик по определенным и малонаселенным регионам с краткосрочным выходом на более известные ГЕО. Таким образом конкуренты будут видеть общую картинку не сильно известного сайта, который не представляет из себя конкурентоспособного противника.

Эксперты отвечают

ЮЮрий

Есть смысл лить на узкие гео?

Проекты с ограниченным гео — с одной стороны более простые, а с другой — крайне «коварные». Простота заключается в упрощение настроек, коварность же — в том, что часть работы вы можете сделать «впустую» (тонко собирая аудиторию при помощи парсера), а также в том, что у вас руки связаны общим размером небольшой аудитории. Поэтому важно уметь расширять аудиторию, изучая детально проект перед тем, как начинать работу.

Стоит вспомнить наиболее часто встречающийся пример: почему на сеть магазинов рыболовных снастей в Москве «ООО» производится меньше DDOS-атак, чем на тот же Wildberries, хотя у «ООО» есть возможность доставки по всей России? Известность. Трафик. Конкурентоспособность. ГЕО.

Узкое таргетирование

Можно ограничить себя более точной связкой по пулу объявлений. Например, создать несколько таргетинговых записей с особой настройкой. Таким образом проект не будет «хватать» весь трафик, а возьмет только некоторое направлений и частичным поглощением.

Наглядный пример — мужчины-рыбаки, которым нужны рыболовные снасти. Владелец «ООО» может обратиться в специальное seo-агентство, где сразу подберут множество вариантов для объявлений со следующими возрастными (например) диапазонами:

- мужчины 24-28 лет;

- мужчины 29-32 лет;

- мужчины 33-40 лет.

Стоит отметить, что по отдельности каждое объявление дает минимум трафика (слишком узкая выборка). Именно поэтому у spy-ботов не будет интереса к исследованию сайта, поиску обратных ссылок и спаму. Если подобные объявления будут найдены, то скорее всего в самом низу списка приоритета для конкурентов.

Это идеальный вариант для тех случаев, когда можно позволить себе более высокий бюджет для рекламы, и весь трафик можно поделить на части с постепенным переключением по рекламным объявлениям (сегодня — молодые люди, завтра — пенсионеры, послезавтра — дети). Также данный способ подойдет под уникальные ГЕО со специфическими офферами.

Дорогие и непопулярные домены

Уникальность — вот, что отличает качественные партнерские связи. Например, если арбитражник хочет лить трафик с пуша и тизерной сети, но не хочет, чтобы кто-то получил его креатив, можно потратиться чуть больше и получить защищенный во всех смыслах домен. Однако использовать это в связке с Фейсбуком* или Гуглом будет невыгодно.

Данная настройка позволяет снизить место креатива в общем списке — на первых местах, как правило, высокотрафиковые предложения, их аналоги и популярные сервисы. Не каждый арбитражник будет спускаться до 500-900 мест, где «спрячется» уникальный домен просто из-за его низкой востребованности.

ВАЖНО! Представленные далее способы позволяют полностью закрыться от spy-сервисов, однако это может негативно сказаться на общем рейтинге сайта при использовании в белых вертикалях.

Подмена ссылок

Данный способ позволяет избавиться от преследования низкосортных spy-сервисов. Основная их особенность заключается в большом интервале проверок — как правило, он составляет от 1 месяца до 1 года или даже 1 раза за всю жизнь (тот самый единственный запуск для анализа).

Именно поэтому в действие приводится следующий алгоритм:

- Создаются два преленда: один — основной, для работы, второй — подделка, для «разведчика».

- В роли «обманки», как правило, используется старый тип сайта, либо один из шаблонников партнерских программ.

- Начинается обычный набор трафика с отслеживанием наличия или отсутствия спаев.

- После появления spy-ботов ссылки рекламных объявлений изменяются на «обманку».

Таким образом результатами исследования ботов станут бесполезные данные, не несущие в себе никакой актуальной ценности, а конкуренты могут и вовсе потерять интерес к проекту.

Клоакинг и трекеры

Несмотря на то, что клоакинг и трекер — это определения, касающиеся «серой» и «черной» вертикалей, опытные арбитражники и seo-менеджеры могут представить, что поисковые системы, как настоящие модераторы, вручную проверяют, по каким ссылкам они проходят, и составляют на основе этого отчетность.

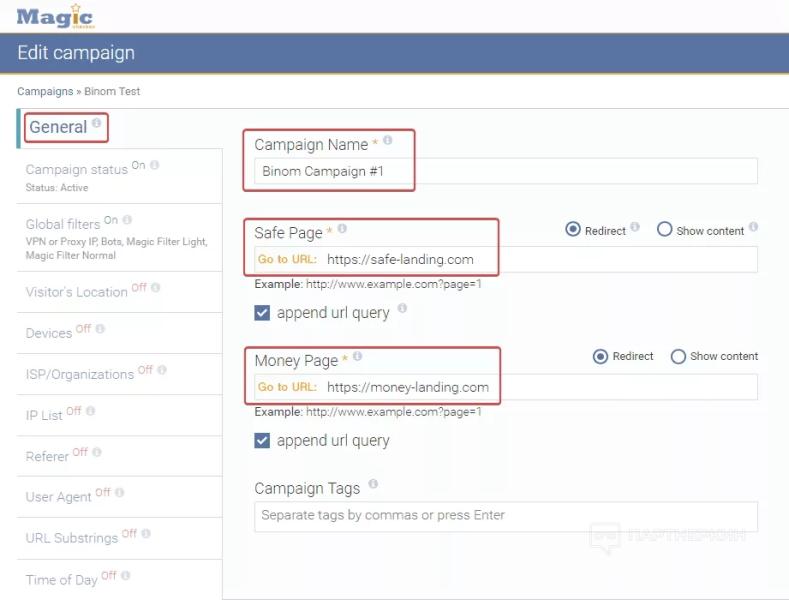

Наиболее важной функцией внутри подобного программного обеспечения можно назвать «antispy» — тот самый кусочек кода, который перенаправляет всех ботов на сайты-пустышки, в то время как живой трафик переходит на целевую страницу. При этом можно порекомендовать следующие программы:

- Magic Checker

Если говорить про рынок в целом, то это лучшая защита от ботов, которая умеет подстраиваться под новые технологии, включенный VPN и обновляет базы данных раз в неделю.

При этом возможна также фильтрация по настройкам:

- IP-прокси VPN;

- бот;

- ГЕО;

- устройство;

- ОС;

- провайдер;

- браузер.

Если ранее выполнялся DNS-запрос по одному из ботов или людей, то, зная IP-адрес, администратор может отправить его в черный список с перенаправлением на пустой лендинг.

Стоит сказать, что в целом Magic Checker — не самое экономичное вложение средств, если дело касается не мировых компаний с большой подверженностью к DDOS-атакам. Начальная стоимость пакета составляет 199 долларов/месяц.

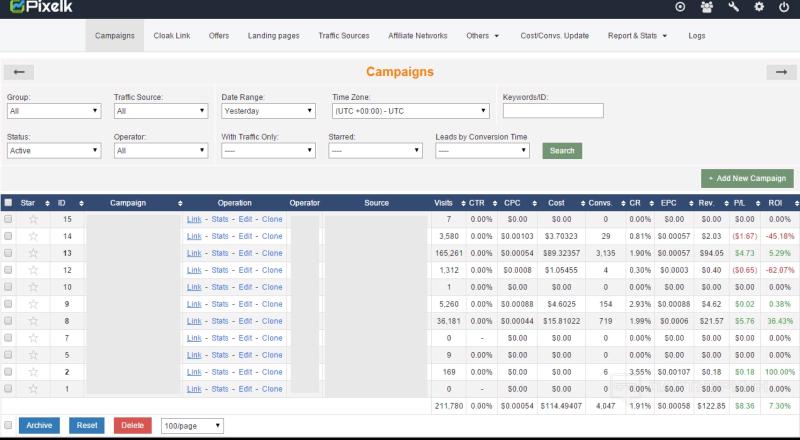

- PixelK

Достаточно удобный инструмент, который точно есть практически у каждого арбитражника — позволяет отслеживать ROI, CPC, EPC и другие показатели, включая:

- уникальность кликов (низкий показатель = дубликация трафика);

- просмотры в процентах;

- степень вовлеченности аудитории;

- среднее время пребывания пользователя на странице;

- среднее время от захода на страницу до совершения целевого действия;

- пользовательские языки.

Из антиспай удобств можно выделить то, что сервис определяет ботов как носителей неизвестного языка и автоматически отправляет их в бан, по креативной странице или фейковый лендинг.

PixelK часто используется маркетинговыми компаниями для отслеживания успехов различных рекламных запусков. В зависимости от объемов трафика минимальный пакет обойдется всего в 50 долларов за месяц.

Избежать спама ссылками можно и нужно — при этом работать можно как вручную, изменяя значения в корневых файлах, так и обратившись к автоматизированным системам, типа плагинов, готовых кодовых решений и спецсервисов. Несмотря на то, что с каждым годом появляется все больше и больше конкурентных разработок, противодействующее программное обеспечение также обновляется вместе с базами данных и знаниями вебмастеров.

*запрещенная в РФ организация