Дипфейк – поддельные фото- аудио- и видеоматериалы, созданные с помощью искусственного интеллекта. Технологии, такие как генеративные состязательные сети (GAN), позволяют реалистично имитировать голос, манеру речи, выражение лица и другие особенности человека. Например, чтобы создавать записи сцен, которых на самом деле не было.

© Коллаж: «Секрет фирмы», Crookedpixel/Ferrari Press/East News, Andrew Parsons / i-Images/EAST NEWS, Кадр видео youtube/ Christian Dior

Оглавление

- Как создают дипфейки

- Почему дипфейки – это угроза

- Когда дипфейки – благо?

- Законно ли использовать дипфейки

- Как страны борются с дипфейками

- Как распознать дипфейк

- Самые впечатляющие дипфейки

Эксперт статьи:

руководитель агентства видеоновостей RUPTLY в России и СНГ

Проще говоря, дипфейк – это «внук» фотошопа и видеомонтажа. Разница в том, что если раньше всевозможные забавные и не очень «жабы» создавались вручную в специальных программах, то теперь дипфейки генерируют нейросети.

Дипфейки делают не только ради смеха, но и для манипуляции и дезинформации. И делают это с каждым годом всё качественней и правдоподобней.

Технологию создания дипфеков разработал в 2014 году студент Стэнфордского университета Иэн Гудфэллоу. Через пару лет она приобрела широкую известность (а заодно и название) благодаря пользователю Reddit с ником deepfake, который начал с её помощью замещать лица порноактрис лицами знаменитостей.

Затем стали популярны приложения, с помощью которых можно было себя состарить, примерить разные цвета волос, а еще посмотреть, как бы ты выглядел, будучи представителем другой расы или даже гендера. Это было в период, когда дипфейки только зарождались.

А в конце 2023 года в ходе прямой линии с Владимиром Путиным к главе государства по видеосвязи обратился его «клон» . Точнее, цифровая копия, которая точно воспроизводила внешность, интонации и мимику национального лидера. «Аватар», созданный студентом Санкт-Петербургского государственного университета, поинтересовался, много ли у президента двойников.

«Вот я смотрю, вы можете быть на меня похожи, и говорите моим голосом. Но я подумал и решил, что похожим на себя и говорить моим голосом должен только один человек. И этим человеком буду я», — не растерялся президент.

Как создают дипфейки

Дипфейки «рождают» генеративно-состязательные нейросети, они же GAN. Это алгоритмы, которые работают на базе машинного обучения и состоят из двух нейронных сетей – генератора и дискриминатора. Генератор создаёт случайные реалистичные изображения, а дискриминатор пытается отличить фейковые материалы от настоящих, что создает процесс обучения и улучшения качества создаваемых материалов.

То же происходит с созданием аудио- или видеороликов на основе общей базы данных, которая есть в свободном доступе в интернете.

Например, программа анализирует сотни фотографий известного певца, сделанные с разных ракурсов и в разные годы и на их основе создает новую – например, где этот певец находится в костюме Адама на нудистском пляже. Всего пара кликов, и контент жёлтой прессе обеспечен надолго.

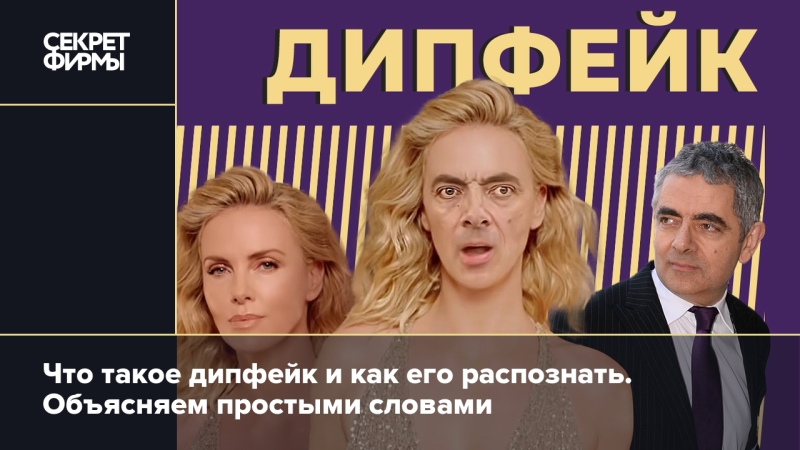

Шарлиз Терон в рекламе Dior

© Кадр видео youtube/ Christian Dior

Шарлиз Терон, выходящая из золотого бассейна. Но когда камера показывает лицо, вместо южноафриканской красавицы на нем 64-летний Аткинсон

© Crookedpixel/Ferrari Press/East News

Пока один из них создает фото- или видеоподделку, другой пытается определить, настоящая она или нет. Если второму «разуму» удалось распознать фальшивку, первый начинает работу сначала, учитывая причины отбраковки. Таким образом тандем трудится до тех пор, пока не выдаст результат, который сочтет достаточно реалистичным. Такое вот киберсотрудничество.

Не стоит думать, что сделать дипфейк можно только со знаменитостями. Даже если ваши аккаунты в соцсетях надежно закрыты, цифровой след в интернете вы все равно оставили, например публичные записи, фотографии и т.д. Этот аспект делает людей уязвимыми, поскольку даже ограниченная информация может быть использована для создания дипфейков. Поэтому будьте начеку.

Почему дипфейки – это угроза

Во-первых и в-главных, дипфейки – это хороший инструмент для мошенников. С помощью нейросети злоумышленник может сгенерировать голос или манеру переписки друга или родственника жертвы и попросить у нее денег в долг.

Так в 2024 году «попал» актер Павел Деревянко, у которого аферист под видом давнего приятеля через Telegram «занял» 300 000 рублей. Получив сумму, жулик не успокоился, и захотел вытянуть из артиста ещё 250 000. Тогда Павел понял, что его обманывают, позвонил в банк и успел заблокировать транзакцию.

Ещё более изощренной оказалась ситуация с директором певца Александра Буйнова. Злоумышленник отправил ему созданное с помощью дипфейка видео из аэропорта, где похожий на Александра мужчина в бейсболке и тёмных очках просит перевести ему $10 000 долларов . Причем сам певец в это время тоже находился в аэропорту, о чём директор знал. Однако после просьбы положить средства на криптокошелёк засомневался, что действительно общался со своим боссом, и не зря.

Опасность ИИ при работе с иллюстрациями наглядно показывает образ Папы Римского

© Сгенерировано в Midjourney

© Сгенерировано в Midjourney

Всего, по данным компании «Информзащита», в 2024 году число атак с использованием дипфейков в финансовом секторе выросло на 13% — до 5,7 тыс. случаев. Это показывает, как важно знать об угрозах и уметь от них защищаться.